Prawdopodobnie DeepSeek zna Wasze sekrety oraz klucze API 😉 Takie ostrzeżenie pojawiło się na łamach Sekurak.pl 1. W dynamicznie rozwijającym się świecie dużych modeli językowych (LLM), gdzie innowacje pojawiają się niemal codziennie, DeepSeek AI szybko zyskał miano znaczącego gracza, budząc zainteresowanie swoimi możliwościami i efektywnością 2. Jednakże, wraz z postępem technologicznym, pojawiają się również nowe wyzwania w obszarze bezpieczeństwa. Niedawne odkrycie dokonane przez badaczy z Truffle Security rzuca nowe światło na potencjalne zagrożenia związane z danymi treningowymi tych zaawansowanych modeli. Wnikliwa analiza publicznie dostępnego zbioru danych Common Crawl, wykorzystywanego do trenowania LLM, w tym DeepSeek, ujawniła obecność licznych, potencjalnie wciąż aktywnych kluczy API i haseł 1. To odkrycie ma fundamentalne znaczenie dla zrozumienia bezpieczeństwa sztucznej inteligencji i rodzi poważne pytania o ochronę poufnych informacji w kontekście uczenia maszynowego. Niniejszy artykuł zagłębia się w fenomen DeepSeek AI, szczegółowo analizuje odkrycie Truffle Security, omawia związane z tym zagrożenia bezpieczeństwa, przedstawia szerszy kontekst bezpieczeństwa LLM oraz oferuje praktyczne zalecenia mające na celu zapobieganie takim problemom.

Fenomen DeepSeek AI: Nowy Gracz na Arenie Sztucznej Inteligencji

DeepSeek AI to chiński startup, który w krótkim czasie zdobył znaczącą pozycję na arenie sztucznej inteligencji, głównie za sprawą swojego zaawansowanego modelu językowego DeepSeek-R1 2. Firma, założona w lipcu 2023 roku przez Liang Wenfenga, współzałożyciela chińskiego funduszu hedgingowego High-Flyer, zadebiutowała swoim chatbotem i modelem DeepSeek-R1 w styczniu 2025 roku 12. Jedną z kluczowych innowacji architektonicznych DeepSeek jest zastosowanie modelu Mixture of Experts (MoE). W przeciwieństwie do tradycyjnych modeli AI, które aktywują wszystkie swoje parametry dla każdego zadania, MoE inteligentnie wybiera i aktywuje tylko najbardziej odpowiednie części modelu, zwane „ekspertami”, w zależności od rodzaju zadania lub danych 2. Ta selektywna aktywacja znacząco zmniejsza obciążenie obliczeniowe, czyniąc system szybszym i bardziej energooszczędnym 13. Specjalizacja ekspertów zapewnia wyższą dokładność i lepszą wydajność w wielu zadaniach, od przetwarzania języka naturalnego po złożone rozwiązywanie problemów 13.

Co więcej, szkolenie modelu DeepSeek-R1 okazało się niezwykle efektywne kosztowo. Podczas gdy szkolenie GPT-4 podobno kosztowało około 100 milionów dolarów, DeepSeek-R1 został wytrenowany za mniej niż 6 milionów dolarów 13. Tę oszczędność przypisuje się między innymi architekturze MoE, która zmniejsza wymagania obliczeniowe, oraz wykorzystaniu mniej kosztownych procesorów graficznych Nvidia H800 do treningu 2. Warto również zauważyć, że modele DeepSeek są udostępniane na licencji MIT jako „open weight”, co oznacza, że oferują większą swobodę modyfikacji niż modele zamknięte, ale mniejszą niż w przypadku oprogramowania w pełni open-source 2. Mimo swojego stosunkowo niedawnego pojawienia się na rynku, DeepSeek-R1 osiąga wyniki porównywalne, a w niektórych przypadkach nawet lepsze, od wiodących modeli, takich jak GPT-4, w różnych zadaniach, w tym w rozumowaniu matematycznym i przetwarzaniu języka naturalnego 2.

Fakt, że DeepSeek koncentruje się na efektywności i udostępnia swoje modele w sposób otwarty, może przyczynić się do jego szerokiego rozpowszechnienia. To z kolei sprawia, że bezpieczeństwo jego danych treningowych i generowanych wyników staje się jeszcze bardziej istotne. Dodatkowo, pochodzenie firmy z Chin wprowadza do dyskusji aspekty geopolityczne i kwestie zarządzania danymi 2.

Odkrycie Wyciekłych Sekretów: Szczegóły Badania Truffle Security

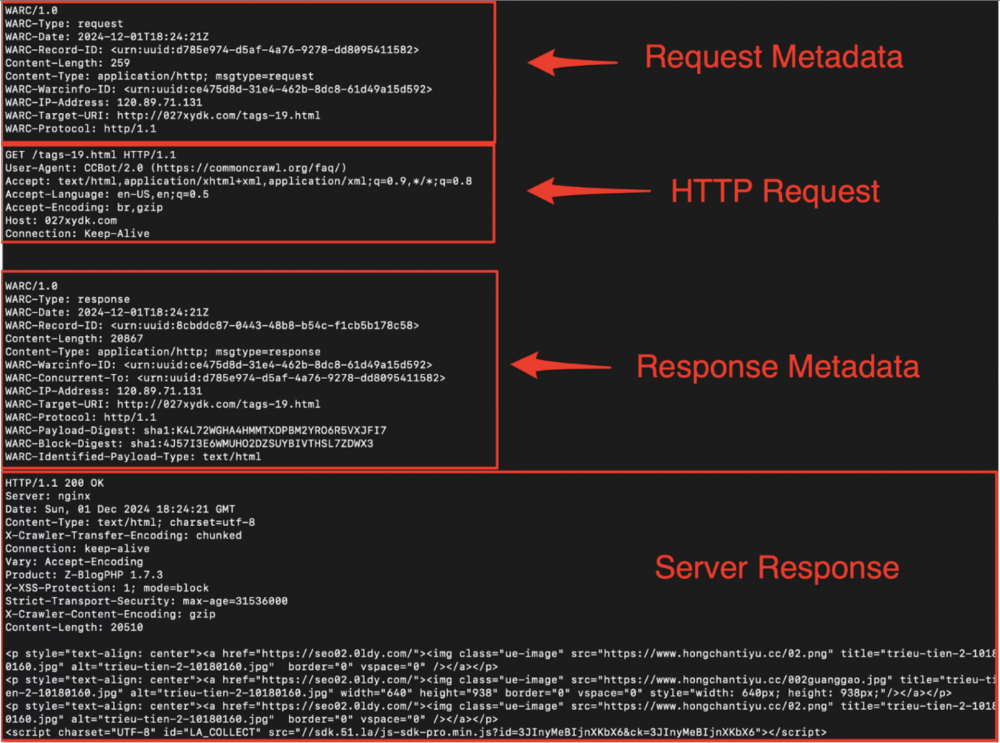

Truffle Security to firma specjalizująca się w wykrywaniu sekretów w kodzie i danych 1. Jej badacze przeprowadzili szczegółową analizę zbioru danych Common Crawl, który stanowi ogromne archiwum danych internetowych, powszechnie wykorzystywane do trenowania dużych modeli językowych, takich jak DeepSeek 1. W wyniku tej analizy odkryto blisko 12 000 „żywych” kluczy API i haseł w archiwum z grudnia 2024 roku 7. „Żywe” sekrety to takie, które pomyślnie przeszły proces uwierzytelnienia z odpowiednimi usługami, co potwierdza ich aktywność w momencie odkrycia 7.

Wśród ujawnionych sekretów znalazły się klucze API do popularnych usług, takich jak Amazon Web Services (AWS), MailChimp, Slack (w postaci webhooków) oraz WalkScore 5. Szczególnie niepokojący był wysoki wskaźnik ponownego wykorzystania tych sekretów na wielu stronach internetowych. Aż 63% odkrytych sekretów powtarzało się na różnych witrynach, co znacząco zwiększa potencjalny zasięg szkód w przypadku ich kompromitacji 6. W jednym ekstremalnym przypadku, pojedynczy klucz API WalkScore pojawił się aż 57 029 razy na 1871 różnych subdomenach 6.

Badacze z Truffle Security przeanalizowali imponującą ilość danych – 400 terabajtów, obejmujących 2,67 miliarda stron internetowych, wykorzystując do tego celu swoje narzędzie TruffleHog, specjalizujące się w wykrywaniu sekretów 6. Warto podkreślić, że problem nie leży w bezpośrednich systemach DeepSeek AI, lecz w błędnych praktykach programistów, którzy umieszczają poufne dane bezpośrednio w kodzie front-endowym swoich stron internetowych. Te hardkodowane sekrety są następnie zbierane przez roboty indeksujące Common Crawl, a w konsekwencji trafiają do danych treningowych modeli LLM 7. Po dokonaniu odkrycia, Truffle Security postąpiło odpowiedzialnie, informując o swoich ustaleniach dotkniętych dostawców usług, aby umożliwić im unieważnienie skompromitowanych kluczy 1.

Ogromna liczba ujawnionych sekretów i ich aktywny status wskazują na powszechny problem z nieprawidłowym zarządzaniem poufnymi danymi w procesie tworzenia oprogramowania. Fakt, że te sekrety znalazły się w danych treningowych, jest niezamierzonym, ale poważnym skutkiem gromadzenia ogromnych ilości publicznie dostępnych danych na potrzeby szkolenia sztucznej inteligencji.

Dlaczego To Jest Ważne: Poważne Zagrożenia Bezpieczeństwa Związane z Ujawnionymi Sekretami

Ujawnienie kluczy API i haseł niesie ze sobą szereg poważnych zagrożeń bezpieczeństwa i może prowadzić do daleko idących konsekwencji 1. Kompromitacja kluczy API umożliwia nieautoryzowany dostęp do wrażliwych danych i funkcjonalności powiązanych z daną usługą. Na przykład, dostęp do kluczy AWS może skutkować naruszeniem bezpieczeństwa całej infrastruktury chmurowej organizacji, w tym wyciekiem danych, nieautoryzowanymi zmianami konfiguracji czy nawet przejęciem kontroli nad zasobami. W przypadku usług takich jak MailChimp, ujawnione klucze API mogą być wykorzystane do przeprowadzania kampanii phishingowych, podszywania się pod markę czy eksfiltracji danych klientów 5. Dostęp do webhooków Slacka może umożliwić nieuprawnionym osobom publikowanie wiadomości w kanałach komunikacji organizacji, potencjalnie wprowadzając chaos i rozpowszechniając fałszywe informacje.

Skutki ujawnienia sekretów mogą być również finansowe, zarówno dla indywidualnych użytkowników, jak i dla organizacji 19. Nieautoryzowane wykorzystanie kluczy API często wiąże się z kosztami, które ponosi właściciel skompromitowanego konta. Dodatkowo, incydenty bezpieczeństwa wynikające z wycieku sekretów mogą generować znaczne koszty związane z reagowaniem na incydent, dochodzeniem, powiadomieniem klientów i naprawą szkód. Utrata zaufania do dotkniętych usług i organizacji, których sekrety zostały ujawnione, jest kolejnym poważnym skutkiem, który może prowadzić do długotrwałych szkód reputacyjnych 19.

Historia zna wiele przykładów incydentów spowodowanych ujawnieniem kluczy API. W lutym 2023 roku wykryto poważną lukę w zabezpieczeniach strony internetowej Lowe’s Market, gdzie publicznie dostępne pliki środowiskowe ujawniły wrażliwe tokeny dostępu do zasobów AWS S3 oraz klucze API do usług zewnętrznych. Wśród nich znajdował się klucz API GrocerKey, który umożliwiał nieuprawniony dostęp do częściowych informacji o kartach kredytowych, adresów klientów i listy najlepiej wydających użytkowników, a także wysyłanie niechcianych zamówień, dokonywanie zwrotów, uruchamianie kampanii reklamowych i resetowanie haseł 16. Innym głośnym przypadkiem było wykorzystanie wyciekłego klucza Microsoft Account Consumer Key przez zaawansowaną grupę APT Storm-0558 16. Te i inne incydenty, takie jak te dotyczące Ubera i Toyoty, podkreślają pilną potrzebę zajęcia się problemem rozrastania się sekretów i wzmocnienia bezpieczeństwa kodu 16. Wysoki wskaźnik ponownego wykorzystania kluczy API dodatkowo potęguje ryzyko, ponieważ kompromitacja jednego klucza może potencjalnie otworzyć drzwi do wielu systemów i kont 6.

Szersze Obawy Dotyczące Bezpieczeństwa Dużych Modeli Językowych (LLM)

Odkrycie wyciekłych kluczy API w danych treningowych DeepSeek to tylko jeden z aspektów szerokiego spektrum obaw dotyczących bezpieczeństwa dużych modeli językowych (LLM) 22. LLM są podatne na różnorodne ataki i luki, które mogą narazić na szwank ich integralność, poufność i dostępność.

Jednym z powszechnych zagrożeń jest atak typu prompt injection, gdzie złośliwie spreparowane dane wejściowe mogą manipulować zachowaniem LLM, powodując, że wykonują niepożądane działania lub generują szkodliwe odpowiedzi 22. Innym poważnym problemem jest wyciek danych, gdzie LLM mogą nieumyślnie ujawnić poufne informacje, które znajdowały się w ich danych treningowych lub zostały im przekazane podczas interakcji 22.

Modele LLM mogą być również celem eksploatacji, gdzie napastnicy wykorzystują luki w ich architekturze lub implementacji, aby generować szkodliwe treści lub podejmować nieautoryzowane działania 23. Ponadto, istnieje ryzyko, że LLM mogą generować niezabezpieczony kod zawierający luki w zabezpieczeniach, co może prowadzić do dalszych problemów bezpieczeństwa w systemach, które wykorzystują ten kod 22.

Inne obawy obejmują kradzież modeli, ataki typu „odmowa usługi” (DoS), zatruwanie danych treningowych oraz generowanie dezinformacji lub szkodliwych treści 23. Bezpieczeństwo LLM to złożona i dynamicznie rozwijająca się dziedzina, a przypadek DeepSeek uwidacznia jeden konkretny aspekt tego szerszego krajobrazu bezpieczeństwa. Podkreśla to, jak ważne jest uwzględnienie całego cyklu życia LLM, od danych treningowych po wdrożenie i interakcje z użytkownikami.

Rola Danych Treningowych w Bezpieczeństwie LLM

Jakość i zawartość danych treningowych mają bezpośredni wpływ na bezpieczeństwo dużych modeli językowych (LLM) 1. Modele uczą się wzorców z danych, na których są trenowane. Jeśli te dane zawierają przykłady niezabezpieczonego kodu, w tym hardkodowane sekrety, istnieje ryzyko, że model nauczy się tych niebezpiecznych praktyk i będzie je powielać w swoich wynikach, sugerując lub generując podobny niezabezpieczony kod 1.

Ponadto, jeśli w danych treningowych znajdują się wrażliwe informacje, takie jak klucze API, hasła czy dane osobowe, model może nieumyślnie je „zapamiętać” i potencjalnie ujawnić w odpowiedzi na odpowiednio spreparowane zapytania 22. Wyzwaniem jest fakt, że zbiory danych używane do trenowania nowoczesnych LLM są ogromne, często liczą setki terabajtów i miliardy rekordów. W przypadku tak rozległych zbiorów, takich jak Common Crawl, zapewnienie całkowitego usunięcia wszystkich wrażliwych informacji jest niezwykle trudne, a wręcz niemożliwe 5.

Zasada „śmieci na wejściu, śmieci na wyjściu” ma silne zastosowanie w kontekście bezpieczeństwa LLM. Jeśli dane treningowe zawierają luki w zabezpieczeniach lub poufne informacje, wynikowy model prawdopodobnie odziedziczy i potencjalnie wzmocni te zagrożenia. Podkreśla to krytyczną potrzebę starannej kuracji i sanitarizacji danych treningowych.

Najlepsze Praktyki Zabezpieczania Kluczy API: Porady dla Programistów i Organizacji

W obliczu ryzyka ujawnienia kluczy API, zarówno programiści, jak i organizacje powinny wdrożyć szereg najlepszych praktyk w celu ich zabezpieczenia 1. Jedną z fundamentalnych zasad jest nigdy nie hardkodować kluczy API bezpośrednio w kodzie aplikacji 5. Zamiast tego, zaleca się wykorzystanie zmiennych środowiskowych do bezpiecznego przechowywania poufnych danych uwierzytelniających 19.

Warto również rozważyć korzystanie z usług zarządzania kluczami, takich jak AWS Secrets Manager czy HashiCorp Vault, które oferują scentralizowane i bezpieczne przechowywanie oraz kontrolę dostępu do sekretów 1. Niezwykle istotne jest wdrożenie regularnych zasad rotacji kluczy API, aby ograniczyć okres ważności potencjalnie skompromitowanych kluczy 9.

Kolejną ważną praktyką jest stosowanie ograniczeń dostępu do kluczy API zgodnie z zasadą najmniejszych uprawnień, przyznając kluczom tylko te uprawnienia, które są niezbędne do ich funkcjonowania 19. Należy również monitorować wykorzystanie kluczy API w celu wykrywania wszelkich anomalii, które mogą wskazywać na ich nieuprawnione użycie 19. Dobrą praktyką jest również używanie oddzielnych kluczy API dla różnych aplikacji lub środowisk 42.

Podczas przesyłania kluczy API przez sieć, należy zawsze korzystać z protokołu HTTPS, aby zapewnić szyfrowanie danych w tranzycie 19. Zaleca się również przeprowadzanie regularnych audytów bezpieczeństwa i rejestrowanie zdarzeń dostępu do kluczy API 19. Nieużywane klucze API powinny być niezwłocznie wyłączane lub usuwane 19. Ostatnią, ale nie mniej ważną kwestią jest edukacja zespołów programistycznych w zakresie najlepszych praktyk dotyczących bezpieczeństwa kluczy API 18.

Wdrożenie solidnych praktyk zabezpieczania kluczy API wymaga połączenia środków technicznych, polityk organizacyjnych i edukacji programistów. Nie wystarczy jedynie bezpiecznie przechowywać klucze; organizacje muszą przyjąć holistyczne podejście, które uwzględnia cały cykl życia kluczy API.

Zapobieganie Umieszczaniu Sekretów w Danych Treningowych AI: Wyzwania i Rozwiązania

Zapobieganie przedostawaniu się poufnych informacji do ogromnych zbiorów danych wykorzystywanych do trenowania modeli AI stanowi znaczące wyzwanie 5. Jednym z kluczowych podejść jest stosowanie technik sanitarizacji danych, mających na celu identyfikację i usuwanie wrażliwych danych ze zbiorów treningowych 39.

Ważne jest również wdrożenie ścisłych środków kontroli dostępu do repozytoriów danych treningowych, ograniczając krąg osób, które mogą uzyskiwać dostęp do tych danych i je modyfikować 39. Można również wykorzystać automatyczne narzędzia do skanowania w poszukiwaniu sekretów, które proaktywnie identyfikują i oznaczają potencjalne sekrety w danych treningowych, zanim zostaną użyte do szkolenia modeli 40.

Techniki prywatności różnicowej mogą być stosowane w celu dodania szumu do danych, chroniąc prywatność poszczególnych osób, a jednocześnie umożliwiając modelom uczenie się ogólnych wzorców 30. Rozwiązaniem może być również wykorzystanie danych syntetycznych, które naśladują charakterystykę rzeczywistych danych, ale nie zawierają faktycznych informacji poufnych 41. Nie można zapomnieć o ustanowieniu jasnych polityk i wytycznych dotyczących rodzajów danych, które mogą być wykorzystywane do treningu AI 46.

Zapobieganie przedostawaniu się sekretów do danych treningowych AI to złożony problem, który wymaga wielowarstwowego podejścia łączącego rozwiązania techniczne, solidne procesy i jasne polityki organizacyjne. Biorąc pod uwagę skalę danych, automatyzacja i proaktywne środki są niezbędne.

DeepSeek i Open Source: Implikacje dla Bezpieczeństwa

Fakt, że DeepSeek jest modelem „open weight” niesie ze sobą unikalne implikacje dla bezpieczeństwa 2. Z jednej strony, zwiększona transparentność może przynieść korzyści, umożliwiając badaczom i społeczności analizowanie modelu pod kątem luk w zabezpieczeniach i potencjalnie przyczyniając się do ich poprawy 2. Z drugiej strony, szersza dostępność modelu zwiększa ryzyko wykorzystania go przez złośliwych aktorów do szkodliwych celów lub prób eksploatacji wszelkich zidentyfikowanych słabości 2. Kontrastuje to z modelami o zamkniętym kodzie źródłowym, gdzie bezpieczeństwo opiera się w większym stopniu na wewnętrznych praktykach dostawcy. Warto wspomnieć, że amerykańska marynarka wojenna podobno zakazała używania DeepSeek ze względu na obawy dotyczące bezpieczeństwa 2.

Otwartość DeepSeek stanowi miecz obosieczny dla bezpieczeństwa. Chociaż sprzyja przejrzystości i kontroli społeczności, obniża również barierę dla potencjalnego nadużycia. Wymaga to silnego nacisku na proaktywne środki bezpieczeństwa i współpracę społeczności w celu identyfikacji i eliminowania luk w zabezpieczeniach.

Podsumowanie i Wnioski: Bezpieczeństwo AI Wymaga Ciągłej Czujności

Odkrycie przeprowadzone przez Truffle Security, dotyczące obecności aktywnych kluczy API i haseł w danych treningowych DeepSeek, stanowi istotne ostrzeżenie dotyczące potencjalnych luk w zabezpieczeniach nie tylko tego konkretnego modelu, ale również innych LLM trenowanych na podobnych zbiorach danych 1. Incydent ten przypomina o krytycznym znaczeniu przyjęcia bezpiecznych praktyk programistycznych, zwłaszcza w odniesieniu do postępowania z kluczami API i innymi poufnymi informacjami.

Konieczne jest wdrożenie solidnych środków bezpieczeństwa na każdym etapie cyklu życia modeli AI, od zarządzania danymi treningowymi po ich wdrożenie i monitorowanie. W miarę jak technologia AI rozwija się i staje się coraz bardziej zintegrowana z różnymi aspektami naszego życia, priorytetowe traktowanie bezpieczeństwa AI staje się nieodzowne. Przypadek DeepSeek jest aktualnym przypomnieniem, że bezpieczeństwo systemów AI nie jest dodatkiem, ale fundamentalnym wymogiem. Wraz ze wzrostem mocy i wszechobecności modeli AI, proaktywne i kompleksowe podejście do bezpieczeństwa jest niezbędne, aby minimalizować potencjalne ryzyko i zapewnić odpowiedzialny rozwój i wdrażanie tej transformacyjnej technologii. Ciągłe badania i współpraca w dziedzinie bezpieczeństwa AI są niezbędne, aby sprostać pojawiającym się wyzwaniom i zapewnić, że postęp w tej dziedzinie będzie szedł w parze z odpowiednimi środkami ochrony.

Cytowane prace:

- Prawdopodobnie DeepSeek zna Wasze sekrety oraz klucze API ;), otwierano: marca 18, 2025, https://sekurak.pl/prawdopodobnie-deepseek-zna-wasze-sekrety-oraz-klucze-api/

- How Deepseek is Changing the AI Landscape – Georgia State University News – Press Releases, Robinson College of Business -, otwierano: marca 18, 2025, https://news.gsu.edu/2025/02/04/how-deepseek-is-changing-the-a-i-landscape/

- Q&A: What Is DeepSeek, the Bargain AI Roiling the Stock Market? – The Darden Report, otwierano: marca 18, 2025, https://news.darden.virginia.edu/2025/01/29/qa-what-is-deepseek-the-bargain-ai-roiling-the-stock-market/

- DeepSeek: How a small Chinese AI company is shaking up US tech heavyweights – The University of Sydney, otwierano: marca 18, 2025, https://www.sydney.edu.au/news-opinion/news/2025/01/29/deepseek-ai-china-us-tech.html

- AI training dataset leaks thousands of live API keys and passwords – Computing UK, otwierano: marca 18, 2025, https://www.computing.co.uk/news/2025/security/ai-training-dataset-leaks-api-keys-and-passwords

- Nearly 12,000 API keys and passwords found in AI training dataset – Bleeping Computer, otwierano: marca 18, 2025, https://www.bleepingcomputer.com/news/security/nearly-12-000-api-keys-and-passwords-found-in-ai-training-dataset/

- Research finds 12,000 'Live’ API Keys and Passwords in DeepSeek’s Training Data Truffle Security Co., otwierano: marca 18, 2025, https://trufflesecurity.com/blog/research-finds-12-000-live-api-keys-and-passwords-in-deepseek-s-training-data

- 12,000 API Keys and Passwords Found in AI Training Datasets – Security Spotlight, otwierano: marca 18, 2025, https://dailysecurityreview.com/security-spotlight/12000-api-keys-and-passwords-found-in-ai-training-datasets/

- 12,000 API keys and passwords were found in a popular AI training dataset – experts say the issue is down to poor identity management | ITPro, otwierano: marca 18, 2025, https://www.itpro.com/security/12-000-api-keys-and-passwords-were-found-in-a-popular-ai-training-dataset-experts-say-the-issue-is-down-to-poor-identity-management

- 12,000+ API Keys and Passwords Found in Public Datasets Used for LLM Training, otwierano: marca 18, 2025, https://thehackernews.com/2025/02/12000-api-keys-and-passwords-found-in.html

- DeepSeek-R1: Technical Overview of its Architecture and Innovations – GeeksforGeeks, otwierano: marca 18, 2025, https://www.geeksforgeeks.org/deepseek-r1-technical-overview-of-its-architecture-and-innovations/

- DeepSeek – Wikipedia, otwierano: marca 18, 2025, https://en.wikipedia.org/wiki/DeepSeek

- DeepSeek AI Explained: What Makes It the Next Big Thing in AI? – DaveAI, otwierano: marca 18, 2025, https://www.iamdave.ai/blog/deepseek-ai-explained-what-makes-it-the-next-big-thing-in-ai/

- DeepSeek AI: A new revolution in Open-Source AI – OpenCV, otwierano: marca 18, 2025, https://opencv.org/blog/deepseek/

- WashU Expert: How DeepSeek changes the AI industry – The Source, otwierano: marca 18, 2025, https://source.washu.edu/2025/02/washu-expert-how-deepseek-changes-the-ai-industry/

- The Silent Threat: Exposed API Secrets Compromising Cybersecurity – 63SATS, otwierano: marca 18, 2025, https://63sats.com/blog/silent-threat-exposed-api-secrets-cybersecurity/

- When Exposed API Keys Spill the Sensitive Data | by Sushant Kamble – Medium, otwierano: marca 18, 2025, https://sushant-kamble.medium.com/when-exposed-api-keys-spill-the-sensitive-data-00b5947f0f5b

- Postman Data Leaks: A Technical Analysis of Exposed Sensitive Information in Postman, otwierano: marca 18, 2025, https://vulcan.io/blog/postman-data-leak/

- API Key Security Best Practices: Secure Sensitive Data, otwierano: marca 18, 2025, https://www.legitsecurity.com/blog/api-key-security-best-practices

- Top 5 API Security Incidents of 2023 | Equixly, otwierano: marca 18, 2025, https://equixly.com/blog/2024/01/05/top-5-api-security-incidents-of-2023/

- Remediating OpenAI API Key leaks – GitGuardian, otwierano: marca 18, 2025, https://www.gitguardian.com/remediation/openai-api-key

- Office of Information Security Guidance on Large Language Models – Penn ISC, otwierano: marca 18, 2025, https://isc.upenn.edu/security/office-information-security-guidance-large-language-models

- Why LLM Security Matters: Top 10 Threats and Best Practices – Perception Point, otwierano: marca 18, 2025, https://perception-point.io/guides/ai-security/why-llm-security-matters-top-10-threats-and-best-practices/

- Navigating the AI Security Risks: Understanding the Top 10 Challenges in Large Language Models – Jit.io, otwierano: marca 18, 2025, https://www.jit.io/resources/app-security/navigating-the-ai-security-risks-understanding-the-top-10-challenges-in-large-language-models

- LLM Security: Top 10 Risks and 5 Best Practices – Tigera, otwierano: marca 18, 2025, https://www.tigera.io/learn/guides/llm-security/

- Top LLM Security Challenges & Their Fixes – Sprinklr, otwierano: marca 18, 2025, https://www.sprinklr.com/blog/evaluate-llm-for-safety/

- Top Security Risks of Large Language Models – Deepchecks, otwierano: marca 18, 2025, https://www.deepchecks.com/top-security-risks-of-large-language-models/

- The C-Suite’s Guide to AI/LLM Security, otwierano: marca 18, 2025, https://www.securityjourney.com/post/the-c-suites-guide-to-ai/llm-security

- LLMs: The Dark Side of Large Language Models Part 1 | HiddenLayer, otwierano: marca 18, 2025, https://hiddenlayer.com/innovation-hub/the-dark-side-of-large-language-models/

- Large Language Model (LLM) Security: Challenges & Best Practices, otwierano: marca 18, 2025, https://www.lasso.security/blog/llm-security

- LLM Security 101: Protecting Large Language Models from Cyber Threats, otwierano: marca 18, 2025, https://blog.qualys.com/misc/2025/02/07/llm-security-101-protecting-large-language-models-from-cyber-threats

- A Bird’s Eye View Of Large Language Model Security – Forbes, otwierano: marca 18, 2025, https://www.forbes.com/councils/forbesbusinesscouncil/2024/02/07/a-birds-eye-view-of-large-language-model-security/

- Securing Applications Powered by Large Language Models (LLMs) | by Fabien Soulis, otwierano: marca 18, 2025, https://medium.com/@SecurityArchitect/securing-applications-powered-by-large-language-models-llms-c6585eeb0d2a

- Understanding and Mitigating Data Leakage in Large Language Models – Medium, otwierano: marca 18, 2025, https://medium.com/@tarunvoff/understanding-and-mitigating-data-leakage-in-large-language-models-bf83e4ff89e7

- Large Language Models: Security & Data Privacy – LanguageWire, otwierano: marca 18, 2025, https://www.languagewire.com/en/blog/llm-data-security

- Data Security Challenges In the LLM Era | Sentra Blog, otwierano: marca 18, 2025, https://www.sentra.io/blog/emerging-data-security-challenges-in-the-llm-era

- Data Leakage Prevention (DLP) for LLMs: The Essential Guide | Nightfall AI Security 101, otwierano: marca 18, 2025, https://www.nightfall.ai/ai-security-101/data-leakage-prevention-dlp-for-llms

- [2403.05156] On Protecting the Data Privacy of Large Language Models (LLMs): A Survey, otwierano: marca 18, 2025, https://arxiv.org/abs/2403.05156

- What is AI Data Security? Key Principles and Best Practices – Wiz, otwierano: marca 18, 2025, https://www.wiz.io/academy/ai-data-security

- The Five Most Common AI Model Risks and How to Prevent Them – Orca Security, otwierano: marca 18, 2025, https://orca.security/resources/blog/5-critical-ai-security-risks/

- Training Data Extraction Attacks: The Essential Guide | Nightfall AI Security 101, otwierano: marca 18, 2025, https://www.nightfall.ai/ai-security-101/training-data-extraction-attacks

- Google Maps Platform security guidance, otwierano: marca 18, 2025, https://developers.google.com/maps/api-security-best-practices

- Best practices for managing API keys | Authentication – Google Cloud, otwierano: marca 18, 2025, https://cloud.google.com/docs/authentication/api-keys-best-practices

- Best Practices for API Key Safety | OpenAI Help Center, otwierano: marca 18, 2025, https://help.openai.com/en/articles/5112595-best-practices-for-api-key-safety

- API Security Best Practices | Curity, otwierano: marca 18, 2025, https://curity.io/resources/learn/api-security-best-practices/

- Five best practices to protect your data privacy when implementing Gen AI – TechInformed, otwierano: marca 18, 2025, https://techinformed.com/five-best-practices-to-protect-your-data-privacy-when-implementing-gen-ai/

- Protecting Trade Secrets: Tips for AI Companies, otwierano: marca 18, 2025, https://www.orrick.com/en/Insights/2025/01/Protecting-Trade-Secrets-Tips-for-AI-Companies